안녕하세요 보나에요!

오늘은 최근에 취득한 자격증인 CKA 자격증 후기를 남겨볼려고 합니다

CKA자격증은 Certified Kubernetes Administrator의 약자로,

쿠버네티스를 하는 사람이라면 한번쯤 시도해볼만한(?) 자격증이라고 생각해요.

저는 100점만점에 82점을 받았는데요! 어떻게하면 시험에 붙을 수 있을지, 자세한 후기 남겨보려고해요.

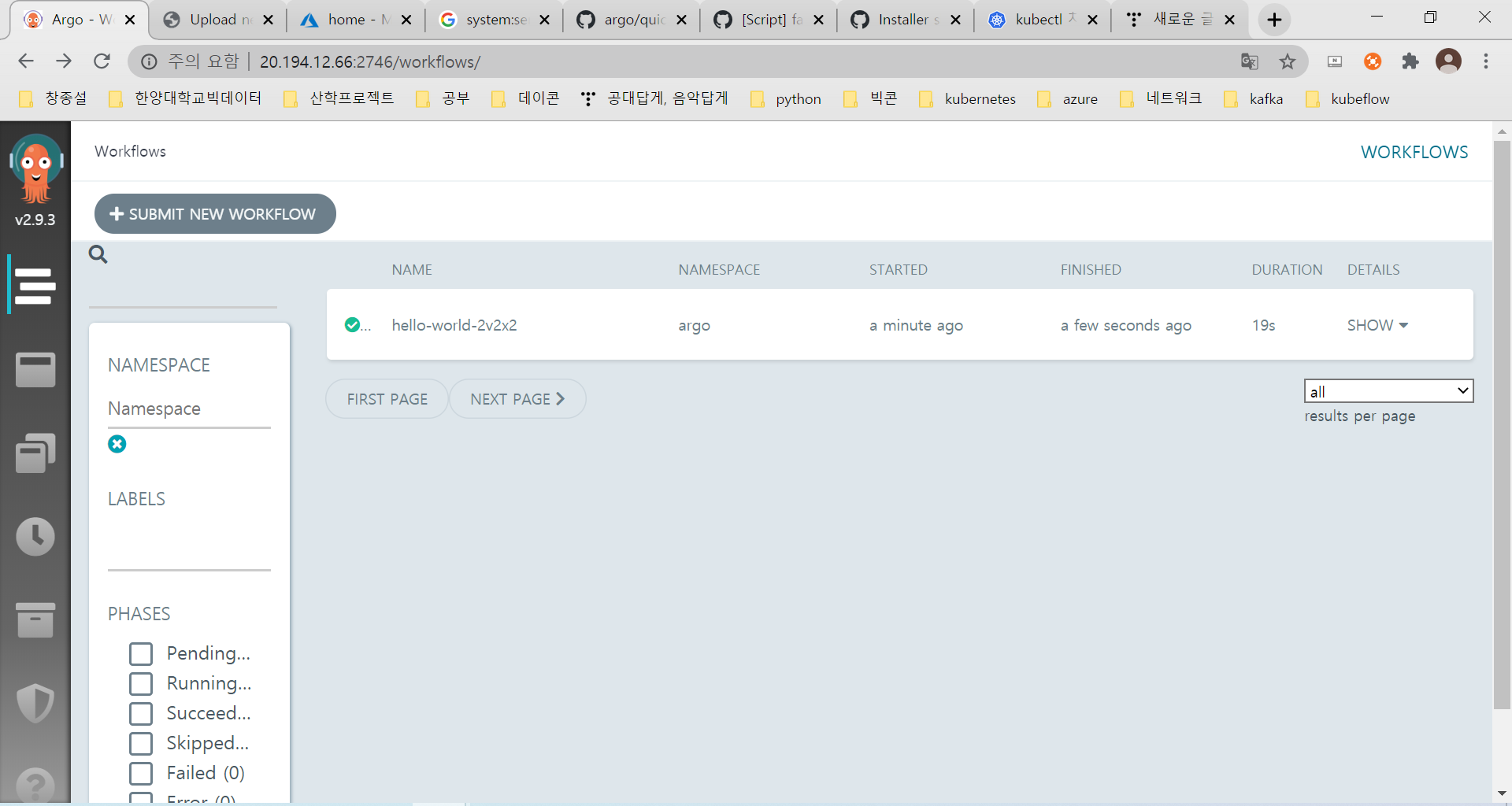

1. 시험 유형

시험 유형은 홈페이지(www.cncf.io/certification/cka/)에서 확인 가능하듯이, 다음과 같아요

각 유형별로 어느정도의 비중이 잡혀있는지 확인할 수 있어요

2. 시험 공부 방법

시험 공부 방법은, 우선 kubectl 명령어에 익숙하셔야 되요.

CKA 시험은 100% Hands-On 시험이기때문에, Linux shell 명령어라든지, K8s 명령어인 kubectl이라든지..

명령어 사용이 잦기때문에 익숙해지는게 필수라고 생각합니다. 명령어에 익숙해지면서,

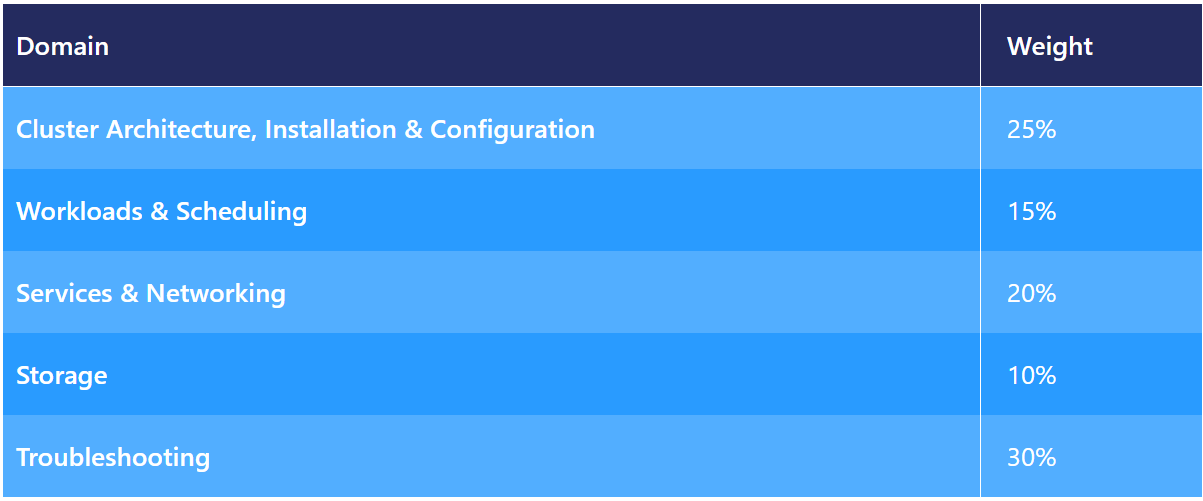

k8s공부도 하실거면 저는 udemy 강의를 완전 추천해요!

이 강의가 CKA공부를 위해서는 독보적인 강의라고 할 수 있어요..

단점이라면 한글자막이 없다는점, 영어자막 또한 수많은 오타가 있다는점..

하지만 장점이라면! 역시! mock exam이라는 모의 CKA 시험이 존재하구요,

챕터마다 practice test 환경을 제공해 주어서 직접 hands-on 으로 연습할 수 있어요!

다시말해, 연습,연습,연습을 통하여 kubernetes 명령어들에 익숙해지고, 왜 이게 개발되었나 생각하다보면

깨닫는게 하나 둘 씩 생길거에요... 저도 아직 다 깨닫진 못했지만 말이에요..(우리 모두 화이팅해봐요)

3. kubectl config use-context [cluster명]에 익숙해지자

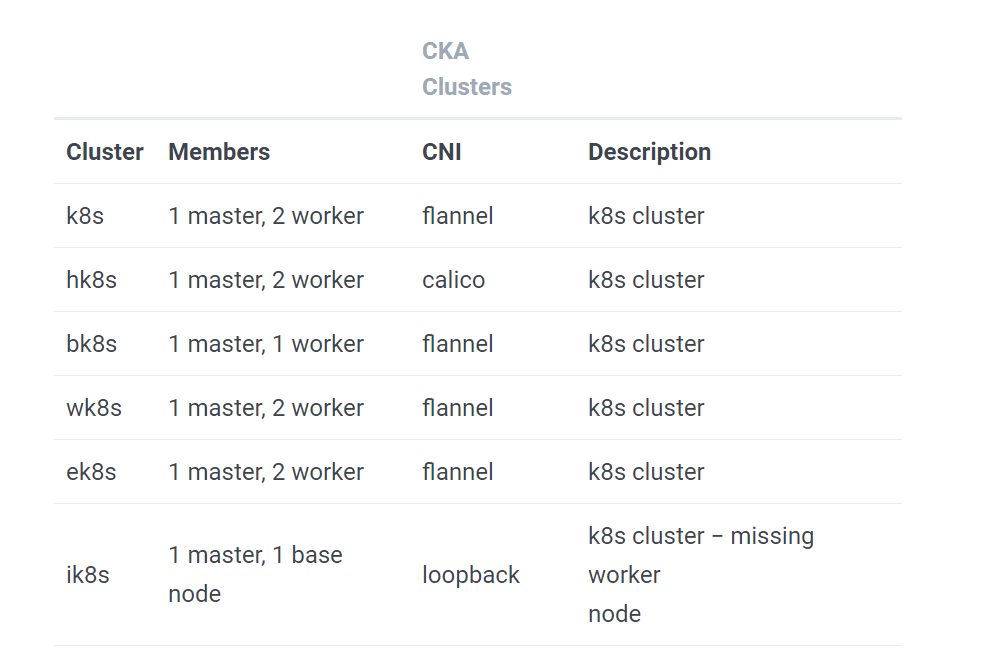

CKA시험은 하나의 cluster에서 시험이 치뤄지는것이 아니에요. 다음과같이 6개의 cluster가 존재해요

docs.linuxfoundation.org/tc-docs/certification/tips-cka-and-ckad 해당 url에 접속하셔서 보시면 알 수 있듯이,

시험자는 매 문제에 해당하는 cluster에서 시험문제를 풀어야해요. 이게 쉬울수도 있을 것이라 생각하는데....

1번문제 풀고 2번문제 풀고.. 마지막문제까지 다풀었다! 라고 생각하면 쉬울거에요.

그런데 1번 막히고, 2번 풀고, 3번막히고.. 다시 1번으로 돌아오고..

이런 과정을 거치다 보면, 내가 context를 이상한데서 풀어버리면..... 그냥 그 시험은 끝이라고 생각이 됩니다....

그러기 때문에!! context를 어디서 작업했나! sudo -i 로 root권한으로 작성했었나! 이런거는 문제를 풀때마다

다시 base node로 가는 것이 중요하다는 점!!! 꼭꼭!! 명심하셔야합니다!!!!

4. kubenetes documentation 활용하기

CKA 시험은 다행히, 오픈북 형식이라 1개의 참고문서를 활용할 수 있어요.

99.9%의 후기를 보면, kubernetes.io/docs/home/

Kubernetes Documentation

Kubernetes is an open source container orchestration engine for automating deployment, scaling, and management of containerized applications. The open source project is hosted by the Cloud Native Computing Foundation.

kubernetes.io

다음 홈페이지를 참고하라고하는데요.. 저도 마찬가지로 해당 홈페이지에서 검색해가며 문제를 풀었습니다..

yaml 파일을 처음부터 만드는 바보는 없으시리라 생각해요..

yaml파일을 kubectl run nginx --image=nignx --dry-run-client -o yaml > q1.yaml 처럼 yaml로 빼신 후 사용하시거나,

docs에서 관련된 유형을 찾으셔서 복사해서 붙여넣어 yaml파일을 완성하세요..

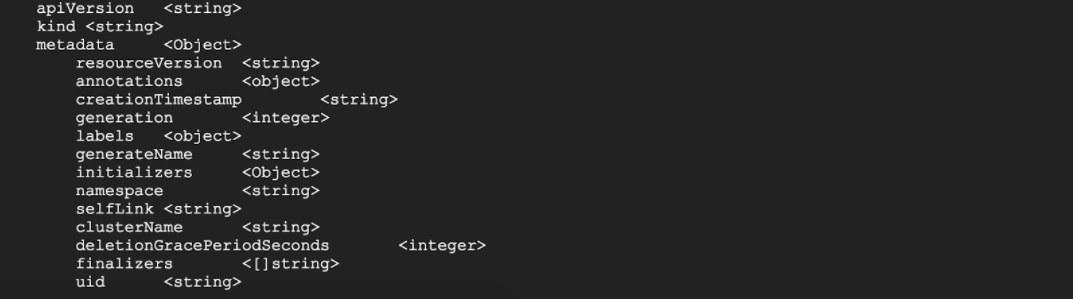

5. kubectl explain [object명] --recursive 활용하자..

해당 명령어로 저는 두세문제는 맞추었다고 생각해요..

yaml 파일은 hierarchy가 탭으로 구분이되요..

예를 들자면,

apiVersion: batch/v1

kind: Job

metadata:

name: hello

spec:

template:

# This is the pod template

spec:

containers:

- name: hello

image: busybox

command: ['sh', '-c', 'echo "Hello, Kubernetes!" && sleep 3600']

restartPolicy: OnFailure

# The pod template ends here다음과 같은 yaml 파일을 보시면, 계층구조가 확실히 보이죠?

그런데 문제는,, spec 밑에 containers 밑에 command를 넣어야하나?(물론 이건 당연한 경우지만)

라는 의문점이 들면서, 계층구조가 헷갈릴 경우가 무조건!! 생겨요..

이게 어떤걸 써야하는지, path인지 paths인지, hostpath인지 hostPath인지 소문자 대문자에 따라서도

오류가 날 수 있꾸요.. 그럴경우에 요긴하게 사용할 수 있는 명령어니까!!

사용해보세요!!

kubectl explain development --recursive 예시

이상으로 후기에 대해 적어보았습니다.. 마지막으로는 자격증을 보여드리며 마치고싶네요!!

나 CKA 자격증 땄다!!!! ㅎㅎㅎ

'IT > Kubernetes' 카테고리의 다른 글

| kubeadm을 사용하여 kubernetes 설치하기 (Ubuntu 18.04) (0) | 2020.12.22 |

|---|---|

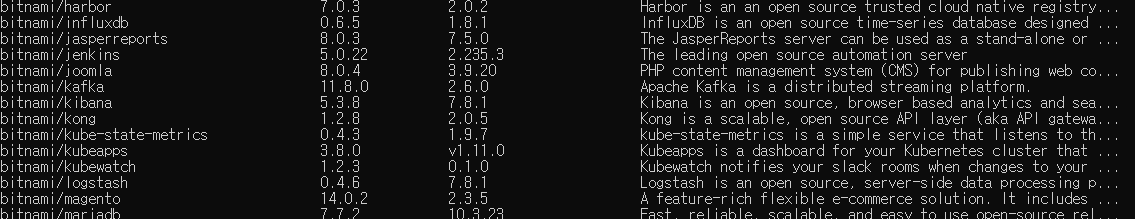

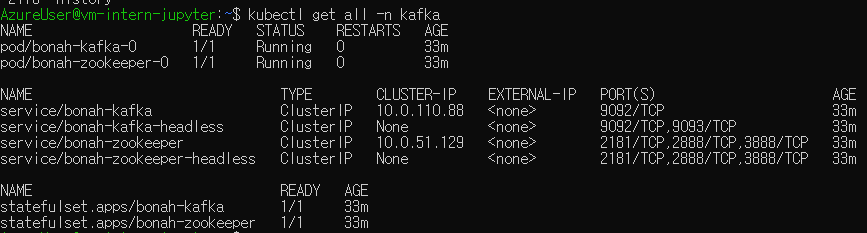

| helm을이용해 k8s에 kafka 설치하기! (1) | 2020.08.11 |

| helm 설치 (0) | 2020.08.11 |

| kubernetes에 jupyter notebook 띄우기 (2) (0) | 2020.08.07 |

| kubernetes multiple cluster일때 cluster 옮기는 방법 (0) | 2020.08.03 |